这份文档基于官方考试指南,对 AWS Certified Generative AI Developer - Professional 认证的五大领域、具体任务和技能要求进行了结构化整理和要点解析,旨在系统化地理解和掌握考试范围。

Summary

该认证的核心是围绕 Amazon Bedrock 这一全托管服务,并整合 AWS 广泛的 AI/ML 与云服务栈(如 SageMaker、Lambda、Step Functions 等),贯穿生成式AI应用的全生命周期。它强调从解决方案架构出发,涵盖基础模型选择与定制、数据工程与检索增强生成(RAG)、提示工程与智能体(Agent)开发,到企业集成、安全治理、成本性能优化,以及最终的测试验证与故障排除。认证要求考生不仅掌握技术实现,更需深刻理解如何在企业环境中实施负责任的AI原则,确保解决方案的安全性、合规性、可靠性与成本效益。

总而言之,该认证标志着持有者具备在 AWS 云上端到端交付生产级、企业就绪的生成式AI应用程序所需的深度知识与实战技能。

[TOC]

概述

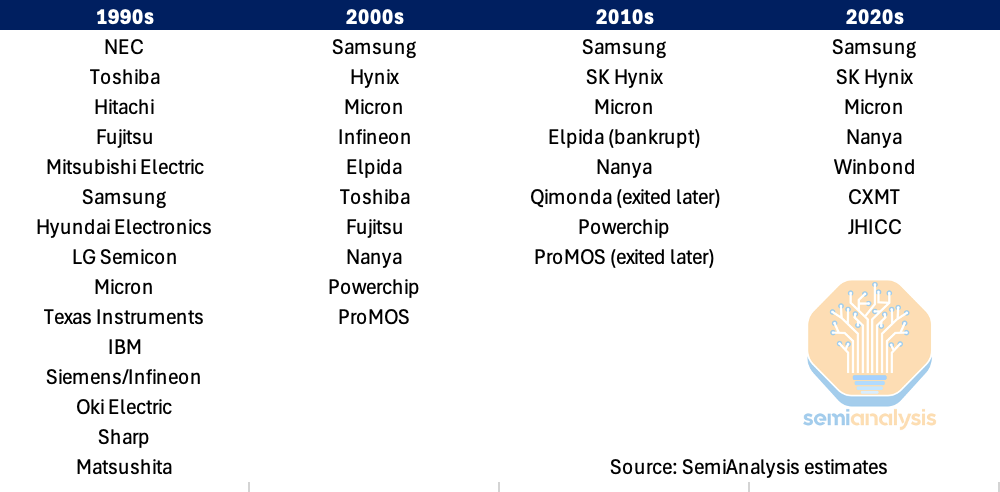

| 领域 |

|

分项 |

分项要点 |

考试占比 |

| 1 |

基础模型集成、数据管理与合规性 |

|

|

31% |

|

|

1.1 |

分析需求与设计 |

|

|

|

1.2 |

配置基础模型 |

|

|

|

1.3 |

数据流水线 |

|

|

|

1.4 |

向量存储 |

|

|

|

1.5 |

增强检索机制 |

|

|

|

1.6 |

提示词工程 |

|

| 2 |

实施与集成 |

|

|

26% |

|

|

2.1 |

智能体AI解决方案与工具集成 |

|

|

|

2.2 |

模型部署策略 |

|

|

|

2.3 |

企业级集成架构 |

|

|

|

2.4 |

基础模型 API 集成 |

|

|

|

2.5 |

应用程序集成模式与开发工具 |

|

| 3 |

AI 的安全、保障与治理 |

|

|

20% |

|

|

3.1 |

输入与输出安全控制 |

|

|

|

3.2 |

数据安全与隐私控制 |

|

|

|

3.3 |

AI 治理与合规机制 |

|

|

|

3.4 |

负责任的 AI 原则 |

|

| 4 |

生成式 AI 应用的运营效率与优化 |

|

|

12% |

|

|

4.1 |

成本优化 |

|

|

|

4.2 |

优化性能 |

|

|

|

4.3 |

监控系统 |

|

| 5 |

测试、验证与故障排除 |

|

|

11% |

|

|

5.1 |

评估系统 |

|

|

|

5.2 |

故障排除 |

|

| 总计 |

|

|

|

100% |

(一)内容领域 1:基础模型集成、数据管理与合规

任务 1.1:分析需求并设计生成式人工智能解决方案

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 1.1.1 |

制定全面的架构设计 |

根据业务需求和技术约束选择合适的基础模型、集成模式、部署策略。 |

| 1.1.2 |

开发技术概念验证 (PoC) |

使用 Amazon Bedrock 等工具在全面部署前验证可行性、性能及业务价值。 |

| 1.1.3 |

创建标准化技术组件 |

遵循 AWS Well-Architected Framework 和 Generative AI Lens,确保跨部署场景的一致性。 |

任务 1.2:选择并配置基础模型(FMs)

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 1.2.1 |

评估并选择基础模型 |

基于性能基准、能力分析和局限性评估,匹配业务用例。 |

| 1.2.2 |

制定灵活架构模式 |

使用 AWS Lambda、API Gateway、AWS AppConfig 实现动态模型选择和提供商切换,无需修改代码。 |

| 1.2.3 |

设计具备弹性的AI系统 |

使用 AWS Step Functions 断路器模式、Bedrock 跨区域推理、跨区域部署、优雅降级策略应对服务中断。 |

| 1.2.4 |

实施模型定制化与生命周期管理 |

使用 Amazon SageMaker 部署微调模型,应用 LoRA 等高效适配技术,利用 SageMaker Model Registry 进行版本控制和自动化流水线。 |

任务 1.3:为基础模型调用实施数据验证与处理流水线

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 1.3.1 |

创建数据验证工作流 |

使用 AWS Glue Data Quality、SageMaker Data Wrangler、自定义 Lambda、CloudWatch 确保数据质量。 |

| 1.3.2 |

处理复杂数据类型 |

使用 Bedrock 多模态模型、SageMaker Processing、AWS Transcribe 处理文本、图像、音频、表格数据。 |

| 1.3.3 |

格式化输入数据 |

为 Bedrock API 准备 JSON,为 SageMaker Endpoint 准备结构化数据,处理对话格式。 |

| 1.3.4 |

提升输入数据质量 |

使用 Bedrock 重新格式化、Amazon Comprehend 提取实体、Lambda 标准化数据以改善模型响应。 |

任务 1.4:设计并实施向量存储解决方案

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 1.4.1 |

创建高级向量数据库架构 |

使用 Amazon Bedrock Knowledge Base、带 Neural plugin 的 Amazon OpenSearch Service、Amazon RDS 与 S3 集成、带向量功能的 DynamoDB。 |

| 1.4.2 |

开发元数据框架 |

利用 S3 对象元数据、自定义属性、标签系统提升搜索精度和上下文感知。 |

| 1.4.3 |

实施高性能向量数据库架构 |

优化 OpenSearch 分片策略,采用多索引、分层索引技术以支持大规模语义搜索。 |

| 1.4.4 |

创建集成组件 |

使用 AWS 服务连接文档管理系统、知识库等资源,实现全面的数据集成。 |

| 1.4.5 |

设计数据维护系统 |

实施增量更新、实时变更检测、自动化同步和定时刷新流水线,确保向量存储信息最新。 |

任务 1.5:设计用于基础模型增强的检索机制

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 1.5.1 |

开发文档分段方法 |

使用 Bedrock 分块功能、Lambda 固定大小分块、自定义分层分块以优化检索性能。 |

| 1.5.2 |

选择并配置 Embedding 方案 |

根据维度和领域适配性选择 Amazon Titan Embeddings 或其他模型,使用 Lambda 批量生成向量。 |

| 1.5.3 |

部署向量搜索解决方案 |

使用 OpenSearch Service、带 pgvector 的 Aurora、Bedrock Knowledge Base 的向量存储功能。 |

| 1.5.4 |

创建高级搜索架构 |

结合语义搜索(OpenSearch)、混合搜索(关键词+向量)、使用 Bedrock 重排序模型提升相关性。 |

| 1.5.5 |

开发复杂查询处理系统 |

使用 Bedrock 进行查询扩展,Lambda 进行查询分解,Step Functions 进行查询转换。 |

| 1.5.6 |

创建统一访问机制 |

通过函数调用接口、模型上下文协议 (MCP) 客户端、标准化 API 模式实现与基础模型的无缝集成。 |

任务 1.6:为基础模型交互实施提示工程策略与治理

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 1.6.1 |

制定模型指令框架 |

使用 Amazon Bedrock Prompt Management 和 Guardrails 定义角色、执行责任AI指南、配置响应格式。 |

| 1.6.2 |

构建交互式 AI 系统 |

使用 Step Functions 实现澄清工作流,Amazon Comprehend 进行意图识别,DynamoDB 存储对话历史。 |

| 1.6.3 |

实施提示管理与治理系统 |

使用 Bedrock Prompt Management 创建参数化模板和审批工作流,S3 存储模板,CloudTrail 和 CloudWatch Logs 跟踪使用。 |

| 1.6.4 |

开发质量保证系统 |

使用 Lambda 验证输出,Step Functions 测试边缘案例,CloudWatch 进行提示回归测试。 |

| 1.6.5 |

提升基础模型性能 |

通过结构化输入、输出格式规范、思维链 (Chain-of-Thought) 指令、反馈循环等迭代优化提示。 |

| 1.6.6 |

设计复杂提示系统 |

使用 Amazon Bedrock 提示流 实现顺序链、条件分支、可复用组件,集成预处理与后处理步骤。 |

(二)内容领域 2:实施与集成

任务 2.1:实施智能体人工智能解决方案与工具集成

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 2.1.1 |

开发智能自主系统 |

使用 Strands Agents 和 AWS Agent Squad 构建多智能体系统,利用 MCP 实现智能体-工具交互。 |

| 2.1.2 |

创建高级问题解决系统 |

使用 Step Functions 实施 ReAct 模式和思维链推理。 |

| 2.1.3 |

开发安全的AI工作流 |

使用 Step Functions 和 Lambda 实施停止条件、超时机制、IAM policies 和断路器。 |

| 2.1.4 |

创建模型协调系统 |

为专门任务使用特定模型,制定自定义聚合逻辑,构建模型选择框架。 |

| 2.1.5 |

开发协同式AI系统 |

使用 Step Functions 编排审核流程,API Gateway 收集反馈,采用人类增强模式。 |

| 2.1.6 |

实施智能工具集成 |

使用 Strands API 定义自定义行为,制定标准化函数定义,用 Lambda 处理错误和验证参数。 |

| 2.1.7 |

开发模型扩展框架 |

使用 Lambda 实现轻量级 MCP 服务器,使用 Amazon ECS 实现复杂工具服务器,使用 MCP 客户端库。 |

任务 2.2:实施模型部署策略

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 2.2.1 |

根据需求部署基础模型 |

使用 Lambda 按需调用,Bedrock 预置吞吐量配置,SageMaker 终端节点。 |

| 2.2.2 |

解决 LLM 部署的独特挑战 |

针对内存、GPU 利用率和 Tokens 处理,优化容器化部署和模型加载策略。 |

| 2.2.3 |

开发优化的部署方法 |

为特定任务选择较小的预训练模型,使用基于 API 的模型级联处理常规查询以平衡性能与成本。 |

任务 2.3:设计并实施企业级集成架构

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 2.3.1 |

创建企业级连接解决方案 |

使用基于 API 的集成连接遗留系统,采用事件驱动架构和数据同步模式。 |

| 2.3.2 |

开发集成式 AI 能力 |

使用 API Gateway 集成微服务,Lambda 处理 Webhook,Amazon EventBridge 驱动事件。 |

| 2.3.3 |

创建安全访问框架 |

使用身份联合、基于角色的访问控制 (RBAC)、最小权限原则保护模型和数据访问。 |

| 2.3.4 |

开发跨环境 AI 解决方案 |

使用 AWS Outposts、AWS Wavelength 满足数据驻留和合规要求,建立云边安全路由。 |

| 2.3.5 |

实施 CI/CD 流水线和网关 |

使用 AWS CodePipeline、CodeBuild 自动化部署与测试,建立集中式生成式AI网关进行抽象和控制。 |

任务 2.4:实施基础模型 API 集成

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 2.4.1 |

创建灵活的模型交互系统 |

使用 Bedrock API 同步请求,AWS SDK 和 Amazon SQS 异步处理,API Gateway 验证请求。 |

| 2.4.2 |

开发实时 AI 交互系统 |

使用 Bedrock streaming API、WebSocket 或 Server-Sent Events (SSE)、API Gateway 分块传输实现流式响应。 |

| 2.4.3 |

创建具备弹性的基础模型系统 |

使用 AWS SDK 实现指数退避重试,API Gateway 管理速率限制,优雅降级,AWS X-Ray 提供可观测性。 |

| 2.4.4 |

开发智能模型路由系统 |

应用程序代码静态路由,Step Functions 动态内容路由,API Gateway 实现基于指标的智能路由和请求转换。 |

任务 2.5:实施应用程序集成模式与开发工具

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 2.5.1 |

创建基础模型 API 接口 |

处理流式响应、管理令牌限制、实施针对模型超时的重试策略。 |

| 2.5.2 |

开发易用的 AI 接口 |

使用 AWS Amplify 构建声明式 UI,采用 API 优先开发,使用 Amazon Bedrock Prompt Flows 无代码构建工作流。 |

| 2.5.3 |

创建业务系统增强功能 |

使用 Lambda 增强 CRM,Step Functions 编排文档处理,Amazon Q Business 提供内部知识工具,Bedrock 自动化数据工作流。 |

| 2.5.4 |

提升开发者效率 |

使用 Amazon Q Developer 生成和重构代码,提供 API 辅助的代码建议和性能优化。 |

| 2.5.5 |

开发高级生成式AI应用程序 |

使用 Strands Agents、AWS Agent Squad 实现原生编排,Step Functions 编排智能体,Bedrock 管理提示链。 |

| 2.5.6 |

提高故障排除效率 |

使用 CloudWatch Logs Insights 分析提示与响应,X-Ray 跟踪 API 调用,Amazon Q Developer 识别错误模式。 |

(三)内容领域 3:AI 安全、安全性与治理

任务 3.1:实施输入与输出安全控制

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 3.1.1 |

开发内容安全系统(输入) |

使用 Amazon Bedrock guardrails 过滤内容,Step Functions 和 Lambda 自定义审核,实施实时验证。 |

| 3.1.2 |

创建内容安全框架(输出) |

使用 Bedrock guardrails 过滤响应,专门模型评估毒性,文本转 SQL 确保确定性。 |

| 3.1.3 |

开发准确性验证系统 |

使用 Bedrock Knowledge Base 进行事实核查,置信度评分,JSON Schema 强制结构化输出以减少幻觉。 |

| 3.1.4 |

创建深度防御安全系统 |

组合 Amazon Comprehend 预处理、Bedrock 模型护栏、Lambda 后处理验证、API Gateway 响应过滤。 |

| 3.1.5 |

实施高级威胁检测 |

使用 Prompt Injection 和越狱检测机制,输入清理,安全分类器,自动化对抗性测试工作流。 |

任务 3.2:实施数据安全与隐私控制

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 3.2.1 |

开发受保护的 AI 环境 |

使用 VPC 终端节点隔离网络,IAM 策略控制访问,AWS Lake Formation 精细数据权限,CloudWatch 监控。 |

| 3.2.2 |

开发隐私保护系统 |

使用 Amazon Comprehend 和 Macie 检测 PII,Bedrock 原生隐私功能,Guardrails 过滤输出,S3 Lifecycle 管理数据保留。 |

| 3.2.3 |

创建以隐私为中心的 AI 系统 |

实施数据掩码,使用 Comprehend PII 检测,匿名化策略,Bedrock guardrails。 |

任务 3.3:实施 AI 治理与合规机制

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 3.3.1 |

开发合规框架 |

使用 SageMaker 生成 Model Cards,AWS Glue 跟踪数据血缘,元数据标签归因,CloudWatch Logs 记录决策。 |

| 3.3.2 |

实施数据源跟踪 |

使用 AWS Glue Data Catalog 注册数据源,元数据标签归因,CloudTrail 审计日志。 |

| 3.3.3 |

创建组织级治理系统 |

构建符合组织政策、监管要求和负责任AI原则的全面架构。 |

| 3.3.4 |

实施持续监控和治理控制 |

自动化检测滥用、漂移和违规,监控偏差,设置自动化告警和修复,实施令牌级脱敏和响应日志记录。 |

任务 3.4:实施负责任的 AI 原则

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 3.4.1 |

开发透明的 AI 系统 |

提供推理展示和证据展示,使用 CloudWatch 收集置信度指标,利用 Bedrock agent tracing 提供推理轨迹。 |

| 3.4.2 |

应用公平性评估 |

使用 CloudWatch 预定义指标,Bedrock Prompt Management 和 Flow 进行 A/B 测试,使用 LLM-as-a-judge 自动化评估。 |

| 3.4.3 |

开发符合政策的 AI 系统 |

使用 Bedrock guardrails 实施政策要求,使用 Model Cards 记录局限性,Lambda 自动化合规检查。 |

(四)内容领域 4:生成式人工智能应用的运营效率与优化

任务 4.1:实施成本优化与资源效率策略

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 4.1.1 |

开发 Tokens 效率系统 |

估算和跟踪令牌使用,优化上下文窗口,控制响应大小,实施提示压缩和上下文修剪。 |

| 4.1.2 |

创建成本效益模型选择框架 |

评估成本-能力模型,基于查询复杂度分层使用模型,衡量性价比,采用高效推理模式。 |

| 4.1.3 |

开发高性能系统 |

使用批处理策略,容量规划,利用率监控,自动扩展,优化预置吞吐量配置。 |

| 4.1.4 |

创建智能缓存系统 |

实施语义缓存,结果指纹识别,边缘缓存,确定性请求哈希,提示缓存。 |

任务 4.2:优化应用程序性能

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 4.2.1 |

创建响应式 AI 系统 |

预计算可预测查询,使用延迟优化的 Bedrock 模型,并行请求,流式传输响应,进行性能基准测试。 |

| 4.2.2 |

提升检索性能 |

优化索引,预处理查询,实施带有自定义评分的混合搜索。 |

| 4.2.3 |

实施吞吐量优化 |

优化令牌处理,使用批处理推理策略,管理并发模型调用。 |

| 4.2.4 |

提升基础模型性能 |

配置模型特定参数(如 temperature, top-k/p),通过 A/B 测试评估效果。 |

| 4.2.5 |

创建高效的资源分配系统 |

针对令牌处理进行容量规划,监控提示和完成模式的利用率,优化自动扩展配置。 |

| 4.2.6 |

优化工作流性能 |

分析 prompt-completion API 调用,优化向量数据库查询,应用降低延迟的技术,采用高效的服务通信模式。 |

任务 4.3:实施生成式人工智能应用的监控系统

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 4.3.1 |

创建全面的可观测性系统 |

跟踪运营指标、性能、模型交互和业务影响指标,使用自定义仪表板。 |

| 4.3.2 |

实施全面的监控系统 |

使用 CloudWatch 跟踪令牌使用、提示有效性、幻觉率,使用 Bedrock Model Invocation Logs 分析请求/响应,进行异常检测和成本监控。 |

| 4.3.3 |

开发集成式可观测性方案 |

整合运营仪表板、业务可视化、合规监控、审计日志和用户交互跟踪。 |

| 4.3.4 |

创建工具性能框架 |

跟踪调用模式,收集性能指标,监控工具调用和多智能体协同,设定使用基准。 |

| 4.3.5 |

创建向量存储运营管理系统 |

监控向量数据库性能,自动化索引优化,实施数据质量验证流程。 |

| 4.3.6 |

开发针对基础模型的故障排除框架 |

使用 Golden Datasets 检测幻觉,使用输出差异分析 (Output Diffing),跟踪推理路径,建立专门的可观测性流水线。 |

(五)内容领域 5:测试、验证与故障排除

任务 5.1:实施生成式人工智能的评估系统

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 5.1.1 |

开发全面的评估框架 |

使用相关性、事实准确性、一致性和流畅性等指标评估模型输出。 |

| 5.1.2 |

创建系统化模型评估系统 |

使用 Amazon Bedrock Model Evaluations、A/B测试、金丝雀测试、多模型评估,衡量令牌效率、延迟-质量比和成本-性能。 |

| 5.1.3 |

开发以用户为中心的评估机制 |

收集用户反馈,建立评分系统,使用标注工作流评估响应质量。 |

| 5.1.4 |

创建系统化的质量保证流程 |

实施持续评估工作流,进行模型输出回归测试,设置自动化质量门控。 |

| 5.1.5 |

开发全面的评估系统 |

进行 RAG 评估,使用 LLM-as-a-judge 自动化评估,收集人类反馈。 |

| 5.1.6 |

实施检索质量测试 |

评估相关性评分、上下文匹配、检索延迟。 |

| 5.1.7 |

开发智能体性能框架 |

衡量任务完成率、工具使用有效性,使用 Amazon Bedrock Agent evaluations,评估多步骤工作流中的推理质量。 |

| 5.1.8 |

创建全面的报告系统 |

使用可视化工具和自动化报告向利益相关者传达性能指标和洞察。 |

| 5.1.9 |

创建部署验证系统 |

使用合成的用户工作流,针对幻觉和语义漂移进行输出验证,确保响应一致性的自动化检查。 |

任务 5.2:对生成式人工智能应用程序进行故障排除

| 编号 |

描述 |

关键要点/AWS服务示例 |

| 5.2.1 |

解决内容处理问题 |

诊断上下文窗口溢出,实施动态分块,优化提示设计,分析截断错误。 |

| 5.2.2 |

诊断并解决 API 集成问题 |

使用错误日志记录、请求验证和响应分析解决生成式AI服务特有的集成问题。 |

| 5.2.3 |

排查提示工程问题 |

使用提示测试框架、版本比较和系统化优化来改善响应质量和一致性。 |

| 5.2.4 |

排查检索系统问题 |

分析响应相关性,诊断嵌入质量,监控漂移,解决向量化和分块问题,优化向量搜索性能。 |

| 5.2.5 |

排查提示维护问题 |

使用 CloudWatch Logs 诊断提示混淆,使用 X-Ray 建立可观测性流水线,检测格式不一致,实施系统化优化工作流。 |

Some Useful Website